يشهد قطاع الذكاء الاصطناعي (AI) نموًا هائلاً، مما أثار تساؤلات حول استدامته. بينما يرى البعض فقاعة وشيكة، تشير بيانات حديثة إلى أن الاستثمار المستمر في البنية التحتية للذكاء الاصطناعي، وعلى رأسها وحدات معالجة الرسوميات (GPUs)، قد يكون مدفوعًا بتقدم تكنولوجي حقيقي وليس مجرد تضخم في الأسعار. هذا التطور يثير تساؤلات حول مستقبل النمو الاقتصادي وتأثيره على قطاعات أخرى.

هل نحن في بداية طفرة حقيقية في مجال الذكاء الاصطناعي؟

أعرب سوندار بيتشاي، الرئيس التنفيذي لشركة Alphabet، عن قلقه بشأن “عناصر غير منطقية” في الازدهار الحالي للبنية التحتية للذكاء الاصطناعي. ومع ذلك، فإن الإعلان عن الإصدار الجديد من نموذج Gemini LLM من Google، والذي يظهر تحسينات كبيرة على الإصدار السابق، يوحي بأن التقدم التكنولوجي لا يزال قويًا.

يرى توماسز تونغوز أن هذه التحسينات تدحض “فرضية جدار القياس”، التي تفترض أن نماذج اللغة الكبيرة (LLMs) قد وصلت إلى نقطة حيث لا يؤدي إضافة المزيد من القدرة الحاسوبية إلى تحسين الأداء. بدلاً من ذلك، استثمرت Google في قدرات حوسبة أفضل – خوارزميات أكثر ذكاءً، وتدريب محسن، وشرائح جديدة – مما أدى إلى نتائج ملموسة.

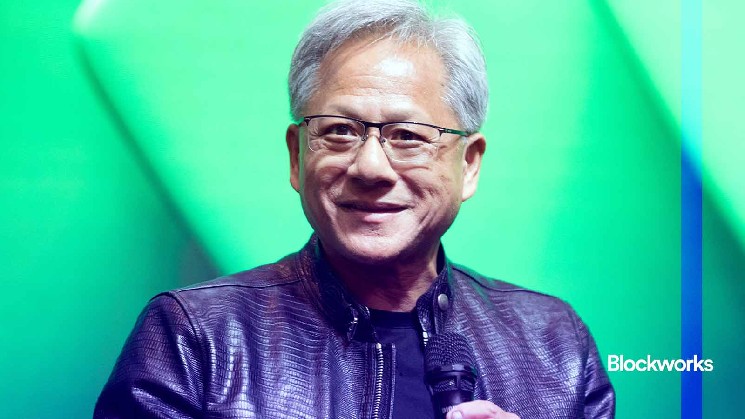

هذا التقدم يشجع المزيد من الاستثمار، كما أكد جينسن هوانغ، الرئيس التنفيذي لشركة Nvidia، مشيرًا إلى أن مبيعات Blackwell “تتجاوز كل التوقعات” وأن وحدات معالجة الرسوميات السحابية (cloud GPUs) مبيوعة بالكامل.

استخدام متتالي لوحدات معالجة الرسوميات

أشارت كوليت كريس، المديرة المالية لشركة Nvidia، إلى أن وحدات معالجة الرسوميات A100 التي تم شحنها قبل ست سنوات لا تزال تعمل بكامل طاقتها. يأتي هذا التعليق ردًا على اتهامات مايكل بيري بأن عملاء Nvidia يقومون بتضخيم أرباحهم بشكل مضلل من خلال جداول استهلاك طويلة الأمد بشكل غير واقعي.

يبدو أن وحدات معالجة الرسوميات تستفيد من “نموذج الاستخدام المتتالي”: يتم استخدام أحدث الشرائح لتدريب النماذج لفترة من الوقت، ثم يتم استخدامها في مهام الاستدلال (inference) قبل أن يتم تخصيصها في النهاية لمهام أقل تطلبًا مثل عرض مقاطع الفيديو على YouTube.

هذا السيناريو يعتبر خبرًا جيدًا للمستثمرين، حيث أن تحسن النماذج، وزيادة الطلب على الشرائح الجديدة، واستمرار فائدة الشرائح القديمة، قد يشير إلى أن شركات الذكاء الاصطناعي قد تكون تقلل من أرباحها الفعلية.

تحديات الطاقة والبنية التحتية

على الرغم من التفاؤل، تشير بعض المؤشرات إلى أن السوق قد بدأ في القلق بشأن توفر الطاقة بدلاً من الطلب على الشرائح. فالطلب على الطاقة اللازمة لتشغيل مراكز البيانات يتزايد بشكل كبير، حيث تقدر شركة Google Cloud أنها ستحتاج إلى مضاعفة قدرتها الحسابية كل ستة أشهر على مدى السنوات الأربع أو الخمس القادمة لتلبية هذا الطلب.

لكن توفير الطاقة اللازمة يمثل تحديًا كبيرًا. تستغرق عملية بناء التوربينات الغازية التي تزود معظم مراكز البيانات بالطاقة ما بين خمس إلى سبع سنوات، والشركات المصنعة لهذه التوربينات لديها طلبات كاملة حتى عام 2030 على الأقل.

إذا لم تتوفر طاقة إضافية، فلن يكون هناك جدوى من شراء وحدات معالجة رسوميات من الجيل الجديد التي تستهلك المزيد من الطاقة؛ فالجيل الأقدم من الشرائح، الذي يستهلك طاقة أقل، قد يكون أكثر فعالية. وبالمثل، لن يكون هناك جدوى من بناء مركز بيانات جديد إذا لم تتوفر توربينات جديدة لتزويده بالطاقة.

هذا يعني أن فقاعة الذكاء الاصطناعي قد تنفجر حتى لو كان الطلب على الذكاء الاصطناعي غير محدود. ويشارك بيتشاي هذا القلق، محذرًا من أنه في حالة انفجار الفقاعة، “لن تكون أي شركة بمنأى عن ذلك، بما في ذلك نحن”.

وفقًا للتحليلات، فإن النمو في مراكز البيانات هو المحرك الرئيسي للاقتصاد الأمريكي، حيث ساهمت بنسبة 93٪ من النمو الإجمالي للناتج المحلي الإجمالي في النصف الأول من العام، على الرغم من أنها تمثل 4٪ فقط من الناتج المحلي الإجمالي.

لذلك، فإن فهم “جدار القياس”، وجداول استهلاك مراكز البيانات، وحالات الاستخدام المتتالية، أمر بالغ الأهمية لأي شخص مهتم بالاقتصاد والأسواق المالية.

تشير البيانات إلى أن الاستثمار في الذكاء الاصطناعي يقترب من مستويات الطفرات الاستثمارية السابقة التي سبقت فقاعات الدوت كوم والإسكان والصخر الزيتي.

في الوقت نفسه، أظهرت بيانات الوظائف المتأخرة زيادة في الوظائف في الولايات المتحدة بمقدار 119 ألف وظيفة في سبتمبر، مما يشير إلى أن سوق العمل لا يزال قويًا.

في الختام، يظل مستقبل الذكاء الاصطناعي غير مؤكد. من المتوقع أن تشهد الأشهر القادمة المزيد من التطورات في التكنولوجيا، بالإضافة إلى تقييم دقيق لتحديات الطاقة والبنية التحتية. سيكون من المهم مراقبة هذه التطورات عن كثب لتقييم ما إذا كان النمو الحالي في الذكاء الاصطناعي مستدامًا أم أنه مجرد فقاعة مؤقتة.